Nvidia giới thiệu thế hệ chip AI mới vượt bậc hơn so với thế hệ cũ

Nvidia đặt tên thế hệ chip AI mới là Blackwell. Con chip Blackwell đầu tiên – GB200 sẽ được bán ra từ cuối năm nay.

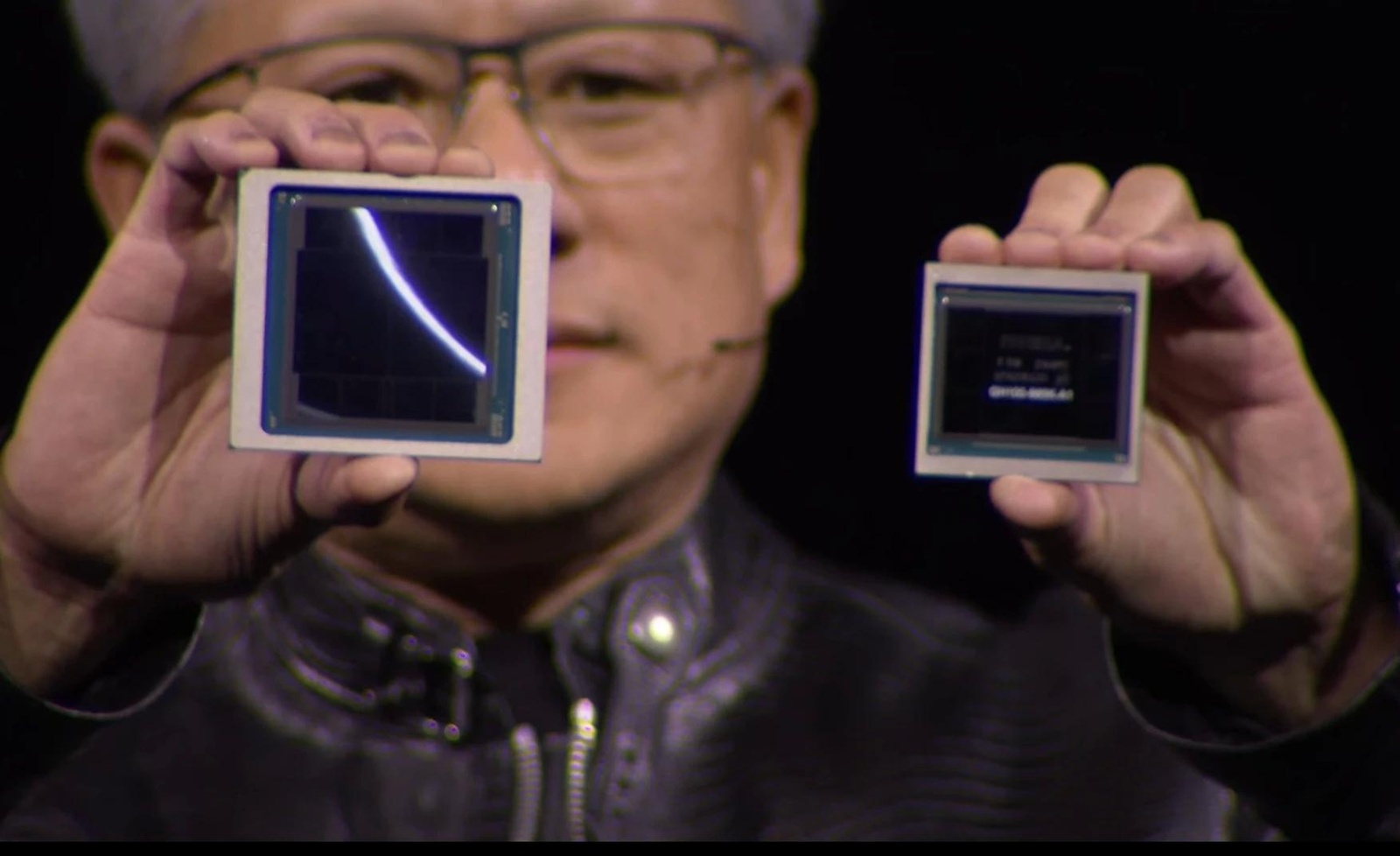

Hôm 18/3, Nvidia giới thiệu thế hệ chip AI mới có tên Blackwell, mạnh hơn nhiều lần so với H100 – chip AI mạnh nhất hiện nay của hãng.

Tại sự kiện dành cho lập trình viên hôm 18/3, Nvidia công bố loạt sản phẩm mới nhằm củng cố vị thế trên thị trường trí tuệ nhân tạo (AI). Giá cổ phiếu của hãng chip này đã tăng gấp 54 lần và doanh thu tăng hơn 3 lần từ khi ChatGPT khởi động cuộc đua AI trên toàn cầu cuối năm 2022. GPU máy chủ cao cấp của Nvidia đóng vai trò quan trọng để đào tạo và triển khai mô hình ngôn ngữ lớn. Các công ty như Microsoft và Meta đã chi hàng tỷ USD để mua chip.

Nvidia đặt tên thế hệ chip AI mới là Blackwell. Con chip Blackwell đầu tiên – GB200 sẽ được bán ra từ cuối năm nay. Nvidia đang cung cấp cho khách hàng nhiều chip mạnh hơn để thúc đẩy các đơn hàng mới. Hiện tại, các khách hàng vẫn đang tranh giành để có được chip H100 Hopper.

"Blackwell nhanh hơn Hopper, nhưng quan trọng là nó có khả năng tính toán trong mạng, yếu tố giúp tốc độ xử lý AI nhanh hơn nữa cũng như thực hiện những công việc khó khăn trước đây, như biến lời nói thành video 3D", CEO Nvidia Jensen Huang nói tại sự kiện GPU Technology Conference - GTC 2024 của công ty ở San Jose, California.

Blackwell có 208 tỷ bóng bán dẫn, cao gấp đôi so với 80 tỷ trên chip H100, có năng lực xử lý AI đạt 20 petaflop (20 triệu tỷ phép tính mỗi giây), gấp 5 lần mức 4 petaflop của H100. Theo Nvidia, trên thực tế, Blackwell xử lý tác vụ nhanh gấp 7-30 lần H100, đồng thời giảm 25 lần chi phí cũng như mức tiêu thụ năng lượng.

CEO Nvidia lấy ví dụ, trước đây việc huấn luyện một mô hình AI 1.800 tham số cần đến 8.000 GPU và 15 megawatt điện. Giờ đây, 2.000 GPU B200 có thể thực hiện khối lượng công việc tương tự với lượng điện năng chỉ 4 megawatt.

Một trong những cải tiến then chốt là hệ thống Transformer Engine thế hệ hai nhân đôi khả năng tính toán, băng thông và kích thước mô hình. Khi kết hợp bộ chuyển mạch NVLink, hệ thống có thể hỗ trợ tối đa 576 GPU giao tiếp với nhau, với băng thông hai chiều 1,8 Tb/giây.

"Không có vấn đề về bộ nhớ, cũng không có vấn đề về bộ nhớ đệm. Đơn giản Blackwell là chip khổng lồ. Tham vọng của nó là vượt lên giới hạn của vật lý", Huang cho biết. "GPU Blackwell là động cơ thúc đẩy cuộc cách mạng công nghiệp AI mới, sẽ hiện thực hóa lời hứa về AI cho mọi ngành công nghiệp".

Theo chu kỳ hai năm một lần, Nvidia sẽ cập nhật kiến trúc GPU với mục đích mang lại bước nhảy vọt lớn về hiệu suất.

“Kiến trúc Hopper thật tuyệt vời, nhưng chúng tôi cần một GPU lớn hơn”, CEO Nvidia Jensen Huang cho biết.

Năm 2022, kiến trúc Hopper, được đặt theo lập trình viên nổi tiếng trong lịch sử Mỹ Grace Hoppe, đã gây nên cơn sốt toàn cầu.

H100, bộ vi xử lý mạnh mẽ nhất mà Nvidia từng chế tạo dựa trên kiến trúc Hopper. Đây cũng là bộ vi xử lý đắt đỏ nhất trong lịch sử công ty, với giá thành lên tới 40.000 USD cho mỗi một đơn vị.

Ban đầu, việc ra mắt được đánh giá là không đúng thời điểm, trong bối cảnh các doanh nghiệp ngành bán dẫn tìm cách cắt giảm chi tiêu khi lạm phát gia tăng.

Đến tháng 11/2022, chatbot mang tên ChatGPT được ra mắt và tạo cơn sốt toàn cầu. Khi đó, Nvidia đã “bước chân” sang lĩnh vực trí tuệ nhân tạo. Tầm nhìn của những người đứng đầu Nvidia một lần nữa lại đi trước thời đại.

Với H100, Nvidia trở thành công ty trị giá 2.000 tỷ USD nhờ cung cấp những con chip quan trọng, dùng để huấn luyện các mô hình trí tuệ nhân tạo (AI) phức tạp.

Sự thành công vượt bậc của Hopper đã khiến giới công nghệ trông chờ thế hệ kiến trúc mới mà Nvidia công bố.

Theo CNBC, GPU Blackwell có kích thước lớn và kết hợp hai khuôn được sản xuất riêng biệt thành một con chip do TSMC sản xuất.

Một trong những công nghệ cốt lõi làm nền tảng cho ChatGPT là động cơ biến áp cũng sẽ xuất hiện trên GB200.

Hãng cũng đã tích hợp con chip AI mới nhất này dưới dạng toàn bộ máy chủ có tên GB200 NVLink 2, kết hợp 72 GPU Blackwell và các bộ phận Nvidia khác được thiết kế để đào tạo các mô hình AI.

Amazon, Google, Microsoft và Oracle sẽ là những nhà cung cấp đầu tiên các phiên bản của Blackwell thông qua nền tảng đám mây. Phía Nvidia cũng tiết lộ Amazon Web Services sẽ xây dựng một cụm máy chủ với 20.000 chip GB200.

Hiện nhà sản xuất này vẫn chưa tiết lộ giá bán của GB200 hoặc các hệ thống sử dụng nó. Theo ước tính của các nhà phân tích, thế hệ H100 dựa trên kiến trúc Hopper có giá từ 25.000 - 40.000 USD mỗi chip, trong khi toàn bộ hệ thống tích hợp GPU này có giá lên tới 200.000 USD.

Tuy có giá bán khá cao, nhu cầu về H100 vẫn lớn đến mức một số khách hàng phải đợi tới 6 tháng mới nhận được hàng.

Bên cạnh GPU mới, Nvidia cũng giới thiệu phần mềm NIM giúp triển khai AI dễ dàng hơn. Theo các quan chức Nvidia, công ty đang dần trở thành một nhà cung cấp nền tảng như Apple và Microsoft hơn là nhà cung ứng chip.

“Blackwell không phải một con chip, đó là tên của một nền tảng”, ông Huang nói. Phó Chủ tịch Nvidia Manuvir Das hứa hẹn phần mềm NIM giúp lập trình viên chạy các chương trình trên mọi GPU Nvidia, dù cũ hay mới, để tiếp cận nhiều người hơn.

Cùng với phần cứng, Nvidia cũng giới thiệu công cụ phần mềm mới, được gọi là Microservice. Bộ công cụ này giúp cải thiện hiệu quả hệ thống cho nhiều mục đích sử dụng khác nhau, giúp doanh nghiệp dễ dàng kết hợp mô hình AI vào công việc hơn, giống như một hệ điều hành máy tính tốt có thể giúp ứng dụng hoạt động tốt.

Ngoài ra, tại GTC 2024, Nvidia ra mắt nền tảng nghiên cứu dựa trên đám mây, sử dụng AI để nghiên cứu và thử nghiệm 6G. Hệ thống sẽ bao gồm một ứng dụng mô phỏng các môi trường như tháp di động đơn lẻ hoặc toàn bộ thành phố, cho phép nhà nghiên cứu và tổ chức thử nghiệm mạng 6G theo thời gian thực mà không cần phải lắp đặt trong thực tế. Các đơn vị đầu tiên tham gia có Nokia, Ansys, Samsung, SoftBank và Đại học Boston.

Minh Tú (t/h)

Cùng chuyên mục

Thị trường livestream Việt Nam chứng kiến sự gia tăng mạnh mẽ

TSMC ra mắt công nghệ sản xuất chip mới thách thức đối thủ lâu năm Intel

Apple giảm gần một nửa sản lượng Vision Pro so với kế hoạch ban đầu

Hơn 3 tỷ người đang sử dụng các nền tảng của Meta mỗi ngày

Trung tâm Cách mạng Công nghiệp 4.0 TP. HCM dự kiến ra mắt vào tháng 9/2024

-

Chuyên gia ‘hiến kế’ để phiên đấu thầu vàng thành công

-

TS. Trần Xuân Lượng: Hành vi người mua nhà đã thay đổi theo phân khúc căn hộ chung cư

-

Hoàn thiện thể chế để mở đường cho doanh nghiệp vượt khó, phát triển

-

Tập trung vào giá trị cốt lõi, doanh nghiệp Việt có thể nâng tầm thương hiệu

-

TS. Lê Xuân Nghĩa: Cần xây dựng gói tín dụng hỗ trợ mới cho nhà ở xã hội bài bản hơn